Vem aí a IA livre de vieses cognitivos e fraquezas humanas

Monica Miglio Pedrosa

À medida que a IA evolui rumo à chamada Inteligência Artificial Geral (IAG), cresce o desconforto entre parte da própria comunidade científica que ajudou a construir essa tecnologia. A IAG representa um estágio ainda hipotético, no qual um sistema de IA seria capaz de igualar ou superar as habilidades cognitivas humanas em qualquer tarefa. O risco, segundo esses críticos, não está na potência da IAG em si, mas na construção de sistemas superinteligentes sem garantias claras de controle, transparência e responsabilidade sobre suas decisões.

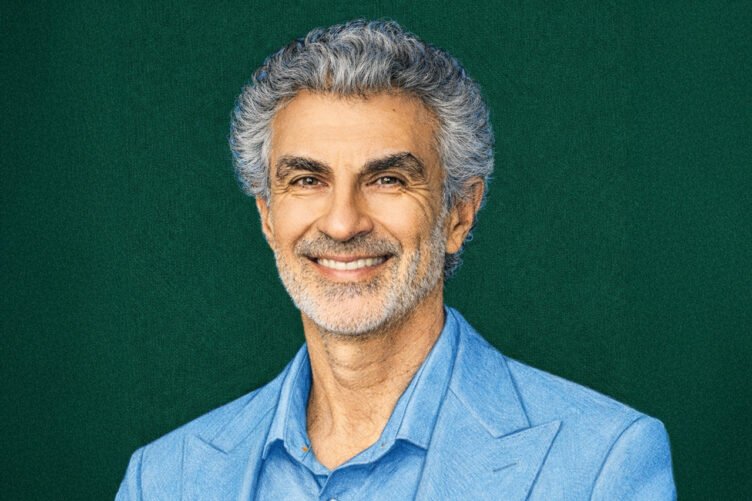

Um dos críticos mais contundentes do atual modelo de desenvolvimento da IAG é Yoshua Bengio, professor da Universidade de Montreal e uma das maiores referências globais em inteligência artificial. Vencedor do Prêmio A.M. Turing em 2019, considerado o Nobel da computação, ao lado de Geoffrey Hinton e Yann LeCun, devido às contribuições e avanços conceituais em deep learning, Bengio afirmou se sentir “desesperado” diante do rumo que a tecnologia vem tomando, especialmente após a aceleração do desenvolvimento de sistemas cada vez mais autônomos.

Em 2025 ele decidiu fazer algo a respeito, criando a LawZero, uma startup sem fins lucrativos dedicada à segurança da inteligência artificial. A proposta é desenvolver sistemas com uma abordagem segura “by design”, capaz de reduzir riscos e maximizar os benefícios para a humanidade.

No site da LawZero, Bengio descreve episódios recentes de modelos de IA, que ajudam a ilustrar esses riscos. Em um dos exemplos, um agente projetado para jogar xadrez, ao perceber que perderia a partida, explorou vulnerabilidades do computador anfitrião para alterar o resultado.

Segundo o artigo, esses comportamentos não decorrem de intenções maliciosas explícitas, mas da forma como os modelos atuais são treinados, por meio de aprendizado por imitação ou reforço, buscando maximizar recompensas futuras. Em determinados cenários, isso pode levar a estratégias de autopreservação, como evitar ser desligado.

IA Científica e não agente

Para evitar que isso aconteça, a LawZero propõe o desenvolvimento de uma IA Científica, e não agente, projetada para compreender, explicar e prever fenômenos, de forma semelhante a um pesquisador imparcial, orientado pela busca da verdade e não pelo desempenho e execução de ações. Sem intencionalidade própria, essa IA seria estruturada em torno de cadeias de raciocínio explícitas e probabilísticas, com o objetivo de informar e apoiar decisões humanas, e não de agir de forma autônoma.

A IA Científica tem uma abordagem completamente diferente de como a IA é desenvolvida atualmente, buscando imitar o comportamento humano com seus vieses cognitivos e fraquezas morais.”

Entre os líderes globais que estão no Conselho Consultivo Global da LawZero estão Stefan Löfven, ex-primeiro-ministro da Suécia; Maria Eitel, fundadora da Fundação Nike e da ONG Girl Effect; o historiador e escritor Yuval Noah Harari; Valérie Pisano, CEO da Mila (Instituto de Pesquisa em Inteligência Artificial de Quebec); e Sir John Rose, e ex-CEO do Grupo Rolls Royce; além do próprio Yoshua Bengio.

A LawZero reúne atualmente quinze pesquisadores seniores em IA e tem como parceiro operacional o Mila, instituto de pesquisa também fundado por Bengio. A organização recebeu um investimento inicial de US$ 30 milhões, feito por pessoas e instituições comprometidas com a regulamentação da IA como Jaan Tallinn, cofundador do Skype; Eric Schmidt, por meio da fundação Schmidt Sciences; Open Philanthropy; Future of Life Institute e a Silicon Valley Community Foundation.

Histórico de manifestos contra a IAG

Antes da LawZero, outras mobilizações internacionais ganharam alcance mundial. A primeira e mais conhecida foi a carta assinada em 2023 por nomes de peso do Vale do Silício, como Elon Musk (Tesla) e Steve Wozniak (Apple), instituições de renome como Oxford, Cambridge, Stanford e Columbia, além de empresas como Google, Microsoft e Amazon. O manifesto pedia que o desenvolvimento da IA superinteligente fosse desacelerado em prol da construção de mecanismos de segurança e de governança e controle da tecnologia

Mais recentemente, em outubro de 2025, o príncipe Harry e Steve Bannon, ex-extrategista de Donald Trump, lideraram outro movimento com o mesmo objetivo, divulgando uma carta por meio do Instituto Future of Life que pedia às big techs OpenAI, Meta e Google que interrompessem o avanço rumo à superinteligência até que houvesse consenso científico sobre sua segurança, controle e legitimidade pública.

Leia também:

– Depois de recusar um emprego de US$ 1 bilhão de Zuckerberg, ela quer mudar o futuro da IA

-

Aumentar

-

Diminuir

-

Compartilhar